原则:

1搜索技术应服务于人类,同时尊重信息提供者的意愿,并维护其隐私权;

2网站有义务保护其使用者的个人信息和隐私不被侵犯。

robots协议(也称爬虫协议,机器人协议等)是一种存放于网站根目录下的文本文件,

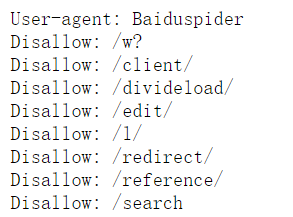

(在一网页中,在网页的URL(即网址)后加上/robots.txt,即可查看)如下图(了解)

通常告诉网络爬虫,此网站中的哪些内容是不应被网络爬虫获取的,哪些是可以被获取的。

robots协议并不是一个规范,而只是约定俗成的,所以并不能保证网站的隐私。

接下来,我从上图截取第一部分来康康其书写规范:

最简单的robots.txt的常规写法两条规则:

User-agent:指定对哪些爬虫生效(例:Baiduspider是百度爬虫)

Disallow:指定要屏蔽的网址(例:上图的8个路径)

Allow :指定允许爬取的网址(上图没有展示,其格式:就是将上图的Disallow改成Allow后跟允许爬取网站的网址)

那么我们在抓取网站的数据时,该如何做呐:

其实很简单,只要遵循爬虫所见即可爬这一原则就可以了。